Procesamiento y herramientas de edición de video

La edición de vídeo es un proceso por el cual un editor fragmentos de vídeo, fotografías, gráficos, efectos digitales o cualquier otro material audiovisual en una cinta de vídeo o un archivo informático llamado máster para generar después las distintas copias. En la mayoría de los casos se incluye audio que puede ser música o el diálogo de personajes, pero también existen ediciones donde únicamente se utilizan medios visuales.

En esta lección veremos también algunas herramientas de vídeo que nos facilitarán la realización de una edición de vídeo, ya sea en el ámbito personal como profesional.

Introducción

[editar]Un vídeo consiste en mostrar una sucesión de imágenes a una determinada frecuencia. Un vídeo digital sigue la misma idea que el vídeo analógico, pero convirtiendo la señal analógica a bits. ¿Cómo se realiza esta transformación analógico-digital?

-Sampling: discretizar el tiempo.

-Quantizing: representar la amplitud con un valor discreto.

La resolución se mide en píxeles horizontales y verticales.

En ocasiones pueden aparecer montaje y edición como sinónimos. Hasta la llegada del siglo XXI, la razón de diferenciar los dos términos era porque cada palabra indica implícitamente los procesos previos requeridos, el material necesario o la calidad con la que trabajaba.

La edición es un término que se asociaba a los soportes magnéticos, ya sea en cinta, memoria flash o disco magnético. Se utiliza material audiovisual grabados en algún soporte magnético, para después, obtener un archivo de ordenador o una cinta de vídeo. Habitualmente requería muchos menos procesos y unos costes bastante inferiores que los necesarios para realizar un montaje, pero la calidad solía ser inferior hasta la llegada del siglo XXI.

El montaje, por su parte, se realizaba con película de cine, del tamaño que fuese, pero siempre partiendo de una cinta fotosensible. Por tanto, se debía recurrir a procesos químicos para realizar copias o duplicados con los que trabajar, lo que suponía líquidos, grandes espacios, cámaras oscuras o tiempos de espera. Durante todo el proceso se podía recurrir al vídeo, pero su objetivo final era obtener una lista de corte de negativo porque la primera película obtenida solía estar muy deteriorada por los sucesivos manipulados. Con dicha lista se realizaba el corte de los negativos seleccionados, dichos negativos se positivaban, se empalmaban y se añadían titulaciones, efectos especiales, banda sonora y demás acciones. El resultado final era una cinta máster de la que se obtenían después los interpositivos necesarios para hacer más copias del montaje.

En el siglo XXI se ha ido produciendo una convergencia de los dos sistemas que actualmente sólo se diferencian por su resolución, no necesariamente por su soporte, al poder ser digitales los dos y manejados en ocasiones con equipos idénticos. La convergencia también se produce en la definición de estos dos conceptos y actualmente el montaje audiovisual puede ser definido como la ordenación narrativa y rítmica de los elementos objetivos del relato. Es decir, la diferencia ahora es que se toma al montaje más como un proceso narrativo y a la edición como un proceso mecánico que estructura y organiza el material grabado de audio y vídeo. Bien es verdad que, por razones de amortización, coste, preferencias o de otra índole, en ocasiones se recurre a medios distintos para el cine y el vídeo.

Además de este trabajo de montaje y edición, también se hizo necesario el corregir y modificar alguno de los materiales obtenidos. Por ello aparece el concepto de postproducción en el que el conjunto de todos estos procesos se realizan después de la producción.

Historia: Fotografía, vídeo, analógico, digital

[editar]Fotografía

[editar]El antecedente más directo del vídeo es la fotografía, cuyo origen tiene sus luces y sus sombras.

Podemos decir que la primera fotografía conocida fue tomada por Joseph N. Niepce (1765-1833), entre los años 1822 y 1826. Se trataba de una fotografía con poca definición, conocida como "Vista desde la ventana en Le Gras".

Esta fotografía fue tomada haciendo uso de una cámara oscura (un dispositivo formado por una caja cerrada con una pequeña apertura por la que entra la luz, proyectándose en la pared opuesta). El acierto de Niepce fue emplear sales de plata sensibles a la luz para tomar imágenes fijas, empleando como soporte para fijar las imágenes metales como el cobre y el estaño.

Pero la fama por el descubrimiento de cómo tomar imágenes fijas no fue de Niepce, sino de un contemporáneo suyo, Louis Daguerre.

Daguerre trabajó junto a Niepce, trabajando juntos en el uso de placas sensibles de plata, cobre y cristal, así como emplear vapores para ennegrecer las imágenes.

Pero Niepce murió en 1833 y Daguerre continuó con su trabajo, naciendo en 1835 el mundialmente conocido daguerrotipo, dispositivo que ha pasado a la historia como primer aparato capaz de tomar fotografías. Este dispositivo triunfó al usar el vapor de mercurio como elemento revelador, a pesar de sus altos tiempos de exposición y de resultar claramente perjudicial para la salud.

Orígenes de la cámara de vídeo y las cámaras digitales

[editar]Las primeras cámaras emplearon tubos de vacío o válvulas termoiónicas (componente electrónico para amplificar, conmutar, o modificar una señal eléctrica mediante el control del movimiento de los electrones en un espacio "vacío" a muy baja presión, o en presencia de gases especialmente seleccionados) como captadores, que empleaban un barrido de electrones y un complejo sistema de lentes, permitiendo transducir la luz captada en señales eléctricas.

Por otra parte, lo más parecido al dispositivo capaz de transmitir vídeo es el iconoscopio, atribuido a Vladimír Kozmich (1889-1982). Aplicaba el mismo principio que las fotografías de Niepce, proyectando las imágenes sobre una placa fotosensible, que dividía la imagen en porciones muy pequeñas, parecido al concepto que hoy se tiene de píxel.

Este sistema de rayos catódicos se abandonó en los años 80, donde se sustituyeron por los CCDs , permitiendo disminuir mucho el tamaño y el peso de las cámaras.

Pero cómo serían por aquel entonces si la primera cámara digital de Steven Sasson (1950- ), un ingeniero eléctrico de Kodak, fue creada en 1975 y pesaba casi 4kg y tardaba 23 segundos en tomar una fotografía. Como podemos ver, en los últimos años ha habido un avance enorme, parejo al boom de la informática.

Captura de vídeo

[editar]Fundamentos biológicos de la visión

[editar]Para poder comprender mejor cómo se realiza la captura de imágenes de vídeo, empezamos por repasar los conceptos biológicos que posibilitan la visión humana, ya que el funcionamiento de las cámaras toma muchas ideas de ello.

El proceso de la visión humana es el siguiente:

- La luz entra por la córnea.

- La pupila controla la cantidad de luz que la atraviesa.

- Se atraviesa el cristalino, cuyo papel es realizar el enfoque de las imágenes.

- Incide en la retina: en ella encontramos dos tipos de células fotosensibles, encargadas de captar los colores o la luminosidad entre otros factores. Estas células son:

- Conos: situados en el centro de la retina, encargados de la visión en alta resolución, especialmente de captar el color. Requieren más luz que los bastones.

- Bastones: situados en la periferia, encargados de la visión monocromática de imagen en baja resolución. Son los encargados de la visión nocturna, con poca luminosidad.

- Una vez formada la imagen, se envía por el nervio óptico hacia el cerebro, donde será procesada.

Partes de una cámara: comparativa con el ojo humano

[editar]A continuación vamos a ver de manera simplificada las partes que componen una cámara de fotografía o de vídeo, mostrando la analogía de algunos de sus componentes.

El elemento más externo es el objetivo, compuesto por un montón de lentes que conducen y enfocan la luz, como hacían tanto la córnea y el cristalino.

Seguido está el diafragma, que controla la cantidad de luz abriéndose y cerrándose, como hacía la pupila.

Análogo al comportamiento de la retina, donde contábamos con los conos y bastones, encontramos el sensor, elemento responsable de convertir la luz a señal eléctrica.

Este sensor puede ser de dos tipos:

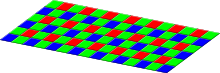

- CCD (Disipositivos de Cargas Acopladas): compuestos por celdas fotoeléctricas, que mediante el efecto fotoeléctrico (la incidencia de suficientes fotones sobre determinados materiales hace que los electrones escapen de estos, produciendo energía), convierten la imagen óptica en señal eléctrica. Estos sensores suelen contar con un filtro o máscara de Bayer, encargada en descomponer en colores RGB por interpolación de 4 fotodiodos vecinos, cada uno sensible a rojo, verde o azul. La proporción de colores que captan estos fotodiodos sigue otro principio biológico, contando con un 50% de diodos sensibles al verde, 25% al azul y 25% al rojo. Esto es así porque el ser humano es mucho más sensible al color verde que a los otros dos colores primario.

- CMOS (Semiconductor Complementario de Óxido metálico): alternativos a los CCD, con un menor consumo pero también menor sensibilidad a la luz.

Si nos encontramos frente a una cámara digital, contamos con dos elementos más a tener en cuenta:

- ADC (Conversor Analógico/Digital): Este elemento es el encargado de transformar la señal eléctrica analógica en una señal digital, de manera que pueda ser tratada por un DSP o por un ordenador de manera más cómoda. Realizan su procesado en tres fases:

- Muestreo: Medición de la señal.

- Cuantificación: Asignar un valor discreto a cada una de las muestras.

- Codificación: Convertir cada valor discreto a código binario.

- DSP (Procesador Digital de Señales): se trata de un procesador especial, de dimensiones reducidas que se encarga del procesado de las señales una vez han sido digitalizadas por el ADC. Es muy rápido, especializado con una arquitectura Harvard, más adecuado para el procesamiento de este tipo de señales.

Partes de la señal de vídeo

[editar]Consta de 3 partes:

- Luminancia.

Es la cantidad lineal de luz, directamente proporcional a la intensidad física y ponderada por la sensibilidad al espectro de la percepción humana a la luminosidad. O dicho de otro modo, una medida fotométrica del brillo de una imagen de vídeo. Cuanto mayor es la luminancia, mayor es el brillo.

La luminancia puede ser calculada como la suma ponderada de los componentes lineales Rojo, Verde y Azul, es decir, puede calcularse a partir de la señal RGB.

Es la forma objetiva de medir la cantidad relacionada con el brillo.

La imagen está formada por luz y color; la luz define la imagen en blanco y negro (es la información que se utiliza en sistemas de blanco y negro). La luminancia representa la información de la parte negra y blanca de la imagen.

En los sistemas digitales se codifica por separado a la señal de color.

Existen estándares diferentes para la codificación del color, NTSC (utilizado en casi toda América, dependencias estadounidenses, Corea, Japón y Myanmar), SECAM (Francia, sus dependencias y ex colonias; mayoría de Rusia) y PAL (resto de Europa; Argentina, Brasil, Groenlandia y Uruguay en América; mayoría de África, Asia y Oceanía).

Sensibilidad a la luminosidad: En un estado particular de adaptación, la visión humana puede distinguir diferentes niveles de luminancia. La razón entre la luminancia de la zona más luminosa de una escena y la más oscura se llama razón de contraste.

- Cromaticidad.

También llamada crominancia, es la representación de color puro en ausencia de brillo. Guarda la información en dos componentes: la diferencia entre el color azul y la luminancia, y la diferencia entre el rojo y la luminancia. Debido a que guarda la información en dos componentes en vez de en los canales RGB, ocupa menos espacio. Algunos formatos de imágenes comprimidas guardan la información como la crominancia.

La crominancia es una señal modulada en cuadratura (es decir en amplitud y en fase). La saturación corresponde aproximadamente a la fase y el matiz corresponde aproximadamente a la amplitud. A la portadora se la denomina subportadora de color y es una frecuencia próxima a la parte alta de la banda, en PAL es de 4,43 MHz; evidentemente, esta frecuencia tiene relación con el resto de frecuencias fundamentales de la señal de vídeo que están referenciadas a la frecuencia de campo que toma como base, por cuestiones históricas, la frecuencia de la red de suministro eléctrico, 50 Hz en Europa y 60 Hz en muchas partes de América.

Frecuencia de muestreo estándar En los sistemas de 525 y 625 líneas la frecuencia de muestreo estándar para los componentes del vídeo digital es de 13.5 MHz. Esta razón produce un número entero de muestras por línea en ambos sistema. En los sistemas de HDTV se muestrea a un múltiplo de la anterior.

Los sistemas de TV se originaron con una frecuencias de campo basadas en la frecuencia de la línea eléctrica: 60 Hz en USA y 50 Hz en Europa. La razón para ello es que el acoplamiento de la ondulación de la fuente de alimentación de un receptor de TV sobre los circuitos, tiene efecto sobre el brillo instantáneo de la pantalla.

- Sincronismos.

Se ocupan de mantener información para alinear las distintas señales, y se distinguen tres clases: de línea u horizontales, de campo o verticales y los referentes al color.

- Los sincronismos de línea indican donde comienza y acaba cada línea de las que se compone la imagen de video. Se dividen en: pórtico anterior, pórtico posterior y pulso de sincronismo.

- Los sincronismos verticales son los que nos indican el comienzo y el final de cada campo. Los campos se refieren a dónde acaba un servicio y empieza otro (por ejemplo en televisión, dónde empieza la señal de vídeo del teletexto de determinado canal). Están compuestos por los pulsos de igualación anterior, pulsos de sincronismo, pulsos de igualación posterior y líneas de guarda (donde en la actualidad se inserta el tele texto y otros servicios). La frecuencia de los pulsos de sincronismo depende del sistema de televisión: en América (con excepción de Argentina y Uruguay, que siguen la norma europea) se usa frecuencia de línea (número de líneas) de 525 líneas por cuadro (y 60 campos por segundo), mientras que en Europa se utilizan 625 líneas por cuadro (312,5 por cada uno de los dos campos en la exploración entrelazada), a una frecuencia de 15.625 Hz, y 50 campos por segundo, (25 cuadros). Estas cifras se derivan de la frecuencia de la red eléctrica en la que antiguamente se enganchaban los osciladores de los receptores.

- En lo referente al color, mantienen la información del color de un modo parecido a la crominancia, modulada en amplitud y en fase. En todos los estándares se modula una portadora con la información del color. En NTSC y PAL lo que se hace es una modulación en amplitud para la saturación, y en fase para el tinte, lo que se llama «modulación en cuadratura». El sistema PAL alterna la 180º en cada línea la fase de la portadora para compensar distorsiones de la transmisión. El sistema SECAM modula cada componente del color en las respectivas líneas.

Características de los flujos de vídeo

[editar]Se componen de:

Número de fotogramas por segundo

[editar]Velocidad de carga de las imágenes (cadencia): número de imágenes por unidad de tiempo. Generalmente se mide en fotogramas por segundo (fps) o como velocidad de refresco (en Hz). El ojo humano necesita más de 15 fps para ver movimiento.

Para viejas cámaras mecánicas cargas de seis a ocho fotogramas por segundo (fps, y para las nuevas cámaras profesionales, 120 imágenes por segundo o más.

Los estándares PAL (Europa, Asia, Australia, etc.) y SECAM (Francia, Rusia, partes de África, etc.) especifican 25 fps, mientras que NTSC (EE. UU., Canadá, Japón, etc.) especifica 29,97 fps.

El cine es más lento con una velocidad de 24fps, lo que complica un poco el proceso de transferir una película de cine a vídeo. Para lograr la ilusión de una imagen en movimiento, la velocidad mínima de carga de las imágenes es de unas quince imágenes por segundo, sin embargo el ojo humano puede distinguir movimiento mucho más fluido por encima de los 48 fotogramas por segundo.

La primera película en emitirse en cines a 48 fps fue el Hobbit, mientras que la BBC ha hecho pruebas con 300fps en la emisión de deportes.

Sistemas de barrido

[editar]Métodos de exploración de las líneas de imágen de video. Existen dos métodos:

- Entrelazado.

Con el fin de evitar el parpadeo o "flicker" que se produce en una imagen de televisión cuando es reproducida en un tubo de imagen debido a la persistencia de los luminofósforos que componen la pantalla del mismo (cuando se estaban trazando las últimas líneas las primeras ya se habían desvanecido) se desarrolló la exploración entrelazada.

La exploración entrelazada 2/1, característica de los sistemas de televisión PAL, NTSC y SECAM así como de algunos otros desarrollados posteriormente, consiente en analizar cada cuadro (frame) de la imagen en dos semicuadros iguales denominados campos (field), de forma que las líneas resultantes estén imbricadas entre sí alternadamente por superposición. Uno de los campos contiene las líneas pares, se le denomina "campo par", mientras que el otro contiene la impares, se le denomina "campo impar". Al comienzo de cada uno de ellos se sitúa el sincronismo vertical. Hay un desfase de media línea entre un campo y otro para que así el campo par explore la franja de imagen que dejó libre el campo impar. La exploración entrelazada de un cuadro de dos campos exige que el número de líneas del cuadro sea impar para que la línea de transición de un campo al otro sea divisible en dos mitades.

En resumen: se dividen las líneas de la imagen en líneas pares e impares y se actualizan por separado. Esto tiene una desventaja, y es que la actualización por separado puede provocar desincronización.

Las especificaciones abreviadas de la resolución de vídeo a menudo incluyen una i para indicar entrelazado. Por ejemplo, el formato de vídeo PAL es a menudo especificado como 576i50, donde 576 indica la línea vertical de resolución, i indica entrelazado, y el 50 indica 50 cuadros (la mitad de imágenes) por segundo.

- Progresivo.

En los sistemas de barrido progresivo, en cada período de refresco se actualizan todas las líneas de exploración independientemente y en orden,es decir, se actualiza primero la primera, luego la segunda, etc. El desarrollo de sistema de representación de imagen diferentes al tubo de imagen, como las pantallas de TFT y de plasma, han permitido desarrollar sistemas de televisión de barrido progresivo. La desventaja en que es necesario un monitor con alta velocidad de refresco.

Un procedimiento conocido como desentrelazado puede ser utilizado para transformar el flujo entrelazado, como el analógico, el de DVD, o satélite, para ser procesado por los dispositivos de barrido progresivo, como el que se establece en los televisores TFT, los proyectores y los paneles de plasma.

Podemos ver un vídeo explicativo de estos dos sistemas de barrido en el siguiente enlace.

Resolución de vídeo

[editar]Especifica el tamaño de la imagen de vídeo, medido en píxeles si el vídeo es digital o en líneas de barrido horizontal y vertical para vídeo analógico. Si el vídeo es en 3D se mide en vóxeles, que miden el volumen de la imagen de vídeo. En el dominio digital, (por ejemplo DVD) la televisión de definición estándar (SDTV) se especifica como 720/704/640 × 480i60 para NTSC y 768/720 × 576i50 para resolución PAL o SECAM. Sin embargo, en el dominio analógico, el número de líneas activas de barrido sigue siendo constante (486 NTSC/576 PAL), mientras que el número de líneas horizontal varía de acuerdo con la medición de la calidad de la señal: aproximadamente 320 píxeles por línea para calidad VCR, 400 píxeles para las emisiones de televisión, y 720 píxeles para DVD. Se conserva la relación de aspecto por falta de píxeles cuadrados.

Los nuevos televisores de alta definición (UHDV) son capaces de resoluciones de hasta 8192 x 4320, es decir, 8192 píxeles por línea de barrido por 4320 líneas. La resolución de vídeo en 3D para vídeo se mide en voxels (elementos de volumen de imagen, que representan un valor en el espacio tridimensional). Por ejemplo, 512 × 512 × 512 voxels, de resolución, se utilizan ahora para vídeo 3D simple, que pueden ser mostrados incluso en algunas PDA.

Relación de aspecto

[editar]La relación de aspecto se expresa por la anchura de la pantalla en relación a la altura. El formato estándar hasta el momento en que se comenzó con la estandarización de la televisión de Alta resolución tenía una relación de aspecto de 4/3 (menos conocido como 1.33:1). El adoptado es de 16/9 (o 1.77:1). La compatibilidad entre ambas relaciones de aspecto se puede realizar de diferentes formas.

Espacio de color y bits por píxel

[editar]El nombre del modelo del color describe el modelo usado para la representación de color de video. El sistema YIQ se utilizó en la televisión NTSC. Se corresponde estrechamente con el sistema YUV utilizado en la televisión NTSC y PAL; y con el sistema YDbDr utilizado por la televisión SECAM. El número de colores distintos que pueden ser representados por un pixel depende del número de bits por pixel (bpp). Una forma de reducir el número de bits por píxel en vídeo digital se puede realizar por submuestreo de croma (por ejemplo, 4:2:2, 4:1:1, 4:2:0).

Calidad de vídeo

[editar]Hay varias métodos para medir la calidad de un vídeo. Se puede medir con métricas formales como PSNR Peak Signal-to-Noise Ratio o subjetivas con calidad de vídeo usando la observación de expertos.

- FR compara la diferencia de calidad entre el video original y el recibido. Es objetivo y referencia al original.

- Métricas basadas en píxeles.

- Métricas basadas en flujos de bits. Son objetivas y no referencian al original.

- Entrevistas y observaciones al usuario. Son subjetivas y no referencian al original.

La calidad de vídeo subjetiva de un sistema de procesamiento de vídeo puede ser evaluada como sigue: - Elige las secuencias de vídeo (el SRC) a usar para la realización del test. - Elige los ajustes del sistema a evaluar (el HRC). - Elige un método de prueba para presentar las secuencias de vídeo a los expertos y recopilar su valoración. - Invita a un número suficiente de expertos, preferiblemente un número no menor de 15. - Realiza las pruebas. - Calcula la media para cada HRC basándote en la valoración de los expertos o no expertos.

Hay muchos métodos de calidad de vídeo subjetiva descritos en la recomendación BT.500. de la ITU-T. Uno de los métodos estandarizados es el Double Stimulus Impairment Scale (DSIS). En este método, cada experto ve una referencia intacta del vídeo seguida de una versión dañada del mismo video. El experto valora entonces el vídeo dañado utilizando una escala que va desde los daños son imperceptibles hasta los daños son muy molestos.

Método de compresión de vídeo

[editar]Se usa una amplia variedad de métodos para comprimir secuencias de vídeo. Los datos de vídeo contienen redundancia temporal, espacial y espectral. En términos generales, se reduce la redundancia espacial registrando diferencias entre las partes de una misma imagen (frame); esta tarea es conocida como compresión intraframe y está estrechamente relacionada con la compresión de imágenes. Así mismo, la redundancia temporal puede ser reducida registrando diferencias entre imágenes (frames); esta tarea es conocida como compresión interframe e incluye la compensación de movimiento y otras técnicas. Los estándares por satélite, y MPEG-4 usado para los sistemas de vídeo domésticos.

Tasa de bits

[editar]La tasa de bits es una medida de la tasa de información contenida en un flujo o secuencia de video. La unidad en la que se mide es bits por segundo (bit/s o bps) o también Megabits por segundo (Mbit/s o Mbps). Una mayor tasa de bits permite mejor calidad de vídeo.

Por ejemplo, el VideoCD, con una tasa de bits de cerca de 1Mbps, posee menos calidad que un DVD que tiene una tasa de alrededor de 20Mbps.

La VBR (Variable Bit Rate – Tase de Bits Variable) es una estrategia para maximizar la calidad visual del vídeo y minimizar la tasa de bits. En las escenas con movimiento rápido, la tasa variable de bits usa más bits que los que usaría en escenas con movimiento lento pero de duración similar logrando una calidad visual consistente.

En los casos de vídeo streaming en tiempo real y sin buffer, cuando el ancho de banda es fijo (por ejemplo en videoconferencia emitida por canales de ancho de banda constante) se debe usar CBR (Constant Bit Rate – Tasa de Bits Constante).

Procesamiento de la señal

[editar]Para pasar de señal analógica a digital, es necesario discretizar los valores. A mayor frecuencia de muestreo, mayor será la calidad. Frecuentemente se utilizan 13.5 MHz.

La clasificación más básica de las señales se produce según su representación respecto a las variables de las que dependen tiempo, espacio:

- Señal analógica es aquella que representa una magnitud de manera continua. Pueden provenir de captadores (o captadores + transductores) como, por ejemplo, un micrófono (para captar sonidos y trasladarlos a señales eléctricas), un termómetro (temperaturas), una sonda barométrica (capta presiones), un velocímetro, etc.

- Señal digital es aquella que toma valores sólo para una cantidad discreta de puntos, y además sus valores son únicamente discretos. Se pueden considerar ejemplos de señales digitales a un programa de ordenador, el contenido de un CD, aunque también podría ser la información recibida de un semáforo, el código Morse, etc.

De manera parecida a la señal digital, una señal discreta sólo tiene valores en una cantidad discreta de puntos. La diferencia está en que estos valores pueden tomar cualquier valor, es decir, no están cuantificados. Estas señales provienen normalmente de conversores analógico-digitales, o lo que es lo mismo, de la discretización de señales continuas. Cuando una señal discreta es cuantificada mediante un cuantificador se transforma en una señal digital.

Un parámetro importante de señales digitales y discretas es la frecuencia de muestreo.

Las señales analógicas se pueden tratar mediante circuitos electrónicos analógicos. Sin embargo la tendencia actual es la de digitalizarlas y procesarlas de forma discreta mediante ordenadores o con un procesador digital de señal (DSP, Digital Signal Processor), que es un microprocesador especialmente diseñado para realizar tareas de procesado digital.

Un conversor, (o convertidor) de señal analógica a digital, (o también CAD de "Conversor Analógico Digital", o ADC del inglés "Analog-to-Digital Converter") es un dispositivo electrónico capaz de convertir una señal analógica de voltaje en una señal digital con un valor binario. Se utiliza en equipos electrónicos como computadora, grabadores de sonido y de vídeo, y equipos de telecomunicaciones. La señal analógica, que varía de forma continua en el tiempo, se conecta a la entrada del dispositivo y se somete a un muestreo a una velocidad fija, obteniéndose así una señal digital a la salida del mismo.

Problemas

[editar]- Aliasing: es un efecto ocurrente en la conversión analógica-digital que provoca que señales distintas parezcan iguales.

- Otros problemas a solucionar:

- Ruido.

- Compensación de movimiento.

- Suavizado de bordes.

- Zoom.

En tiempo real

[editar]Requiere un tratamiento de la señal lo más rápidamente posible para mantener una cierta sincronización con los eventos de entrada.

- Limitaciones:

Las aplicaciones DSP (Procesador digital de señales) quedan limitados a casos donde la frecuencia de muestreo es suficientemente menor a la velocidad de ejecución de instrucciones.

- Desafío:

- Código.

- Compacto para ser ejecutado en tiempo real.

- Buena cantidad de instrucciones entre muestras.

Ventajas de la digitalización

[editar]Hay una serie de motivos por los que se ha digitalizado toda la fotografía y el vídeo, entre los que destacamos:

- Detección de ruido: Mejor reconstrucción de una señal con ruido, llevando a cabo si es necesario un proceso de amplificación.

- Mayor detección y corrección de errores: basándose sobre todo en la redundancia.

- Mayor sencillez del procesamiento.

- Generación infinita de copias sin pérdidas de calidad.

- Compresión de datos (con o sin pérdidas ) mucho más eficientes.

- Muchos métodos de almacenamiento, compatibles con todos los dispositivos actuales, discos duros, memorias flash...

- Gran sencillez de difusión, desde su aplicación en televisión hasta la venta online de películas.

Herramientas de edición de vídeo

[editar]Las herramientas de vídeo se clasifican en dos grupos:

Captura de la pantalla

[editar]- Adobe Captivate.

Es una aplicación en forma de estudio de edición que permite a los usuarios crear de forma fácil simulaciones de muestreo para presentaciones basadas en tomas o "capturas" de video en la pantalla del monitor y reproducibles en formato SWF. Se utiliza para aprendizaje online interactivo (eLearning), utiliza HTML5 que sirve para cualquier plataforma de implantación.

Características:

-Creación sencilla de experiencias de aprendizaje online interactivo.

-Contenido multimedia sofisticado para atraer a los estudiantes.

-Elaboración sencilla de cuestionarios.

-Publicación en prácticamente cualquier lugar.

-Calificación, seguimiento e informes.

Para más información en: Adobe_Captivate

- Wink (gratuito, freeware)

Wink permite hacer capturas de pantalla de manera automática (accionando el ratón, las teclas del teclado, o el timer), así como capturas de movimiento del ratón e inclusive una captura de audio (opcional).

Los videos pueden ser editados antes de la publicación:

- Permite agregar globos de comentarios, pausas, imágenes (soporta la transparencia PNG)(transparencia configurable), comentarios de audio, enlaces hacia sitio web o hacia otras partes de la animación.

-Salida en SWF (Flash), HTML, EXE, PDF o Postscript.

-Los videos Wink son navegables (Posibilidad de añadir pausas, con botones de navegación, lo que no es posible en CamStudio).

Las salidas en formato Flash de Wink tienden a ser más compactas que las de CamStudio. Wink permite igualmente añadir comentarios visuales y de audio, añadir navegación, lo que es una ventaja (pausas automáticas durante la presentación por ejemplo).

Para más información en: Wink

- Fraps.

nombre derivado del inglés frames per second, es un programa de benchmark para aplicaciones 3D o videojuegos teniendo la posibilidad de hacer capturas (tanto screen como video). Fraps es una aplicación de Windows universal que se puede utilizar con juegos usando DirectX o tecnología Gráfica OpenGL.

Características:

-Cuenta con una interfaz sencilla de usar.

-Graba el vídeo en formato Avi con una claridad impresionante.

-Solo basta con apretar una tecla para empezar a grabar el juego de tu elección.

-Consume muy pocos recursos del CPU.

Para más información en: FRAPS

- Camtasia.

Son conjuntos de programas, creados y publicados por TechSmith, para la creación de tutoriales en vídeo y presentaciones directamente a través de screencast, a través de un plug-in de grabación directa a Microsoft PowerPoint. También disponible para móviles.

Características:

-Reproducción de archivos en cualquier tamaño.

-Sencillo, fácil de utilizar y compartir los vídeos creados en casa o en el lugar de estudio.

-Posee una buena precisión para la captura del movimiento en pantalla.

-Contenido profesional en poco tiempo de producción.

-Permite editar audio y vídeo.

-Las aplicaciones creadas con éste programa se pueden integrar con otros programas como PowerPoint, Movie Maker , Audacity, FrontPage.

Para más información en: Camtasia_Studio

- CamStudio.

Es un software open-source escrito en C++ para Windows que graba lo sucedido en pantalla. Los vídeos se guardan de manera predefinida en formato AVI; aunque se pueden convertir a Flash Video.

Originalmente producida por RenderSoft fue más tarde adquirida por eHelp Corporation, dueño la competencia. Tras una serie de transacciones, parece que acaba perteneciendo a Adobe.

En 2014 hubo informes de virus troyanos que procedentes del software descargado de la página oficial.

El software ha acabado en desuso, y la página abandonada.

El software permite:

-Cambiar de formato los vídeos grabados.

-Elegir qué ventana se graba, recortar la parte de la pantalla que se quiere grabar.

-Añadir varios efectos.

Para más información: CamStudio

No lineal

[editar]- Windows Movie Maker.

Es un programa de software de edición de vídeo de Microsoft. Es una parte de Windows Essentials suite de software y ofrece la capacidad de crear y editar vídeos, así como publicarlas en OneDrive, Facebook, YouTube y Flickr.

Carácteristicas:

-Transiciones de vídeo.

-Efectos de vídeo.

-Importación de imágenes, vídeo y audio.

-Creación de títulos o créditos.

-Una herramienta de automovie que sirve para organizar imágenes en la linea de tiempo.

Para más información: Windows_Movie_Maker

- iMovie.

Es una aplicación de software de edición de video creado por Apple Inc. como parte de la suite de aplicaciones iLife para Macintosh, el cual permite a los usuarios editar sus propias películas hechas en casa.

Características:

-Vídeos de importación de diversas fuentes.

-Editar vídeos con funciones.

-Transiciones y efectos especiales.

-Foto y edición de audio.

-Los títulos y efectos de texto.

-Exportar los Proyectos Fin de Carrera.

Para más información: IMovie

- Adobe After Effects.

Es una aplicación que tiene forma de estudio destinado para la creación o aplicación en una composición, así como realización de gráficos profesionales en movimiento , de montaje de vídeo y de efectos especiales audiovisuales, que desde sus raíces han consistido básicamente en la superposición de capas.

Características:

-Cinema 4D Lite y pipeline 3D en vivo entre Cinema 4D y After Effects.

-Refine Edge tool, Roto Brush, Refine Edge y Refine Soft Matte.

-Warp Stabilizer VFX, mejoras del effecto Warp Stabilizer effect.

-Mejoras del 3D Camera Tracker.

-Posibilidad de encontrar instancias de material, fuentes, efectos y metraje desaparecidos.

-Posibilidad de hacer snap a características de las capas como puntos de ancla y máscaras.

-Remuestreo bicúbico.

-Pixel Motion Blur.

Para más información: Adobe_After_Effects

- Final Cut Pro.

Es un software de edición de vídeo no lineal desarrollado por Apple. El software permite a los usuarios registrar y transferir vídeo a un disco duro, donde puede ser editado, procesado y posteriormente publicado a una gran variedad de formatos.

Caracteristicas:

-Edición en múltiples ángulos con sincronización automática y soporte para formatos y velocidad de cuadros mixtos, soportando hasta 64 ángulos de cámara.

-Chroma keying avanzado con herramientas para el muestreo de color y ajustes de bordes.

-Reconexión de medios manual para asociar proyectos y eventos a nuevos archivos.

-Capacidad de importar y editar gráficos en capas de Photoshop.

-XML con soporte para grados de colores primarios, parámetros de efectos, y fotogramas claves de audio.

-Transmisión de monitoreo con dispositivos PCIe y Thunderbolt de terceros.

Para más información: Final_Cut_Pro

- Adobe Premiere Pro.

Es una aplicación en forma de estudio destinado a la edición de vídeo en tiempo real.

Características:

-Es un software de edición de vídeo y sonido digital, altamente utilizado de interfaz bien diseñada e intuitiva que supone mayor facilidad para su manejo.

-Herramienta profesional con amplísima variedad de opciones.

-Requiere un mínimo de conocimiento técnico para un uso óptimo.

-La edición de video se hace a tiempo real.

-Alternativa a tener en cuenta respecto a los programas de edición tradicionales como Avid o Final Cut.

-Soporte para edición de alta calidad HD en tiempo real. (a partir de la versión premiere pro cs3).

-Compatibilidad con el resto de programas de la marca (Photoshop, After Effects)

Para más información: Adobe_Premiere_Pro

- Media Composer.

Es el sistema de edición digital de vídeo para cine, televisión y otros medios más probado y aceptado en el sector audiovisual. Edita en las instalaciones, en la nube, bajo demanda, mediante un acceso mensual o utilizando una licencia.

Características:

-Edita 4K y otros contenidos de alta resolución en modo nativo.

-Trabaja con la Independencia de la Resolución de Avid.

-Consigue mejores resultados con menos ancho de banda.

-Reproduce contenidos de alta resolución ProRes y XAVC-I en modo nativo.

-Produce una acción con más detalles.

-Produce imágenes más vívidas y con más realismo.

-Elimina la espera con la renderización y transcodificación en segundo plano.

-Supera los retos tecnológicos presentes y futuros.

Para más información: Media_Composer

- Sony Vegas.

Sony Vegas es una herramienta software de edición de vídeo y audio, sus últimas versiones pueden ser instaladas en PC con sistema operativo Windows, desde el 7 en adelante. No requiere ningún hardware específico para funcionar correctamente. Originalmente comenzó como editor exclusivo de audio, pero fue evolucionando hasta alcanzar su funcionalidad actual.

Sony Vegas es fiel a sus raíces, y sigue un paradigma de edición de vídeo similar al usado en la edición de audio. Los efectos pueden aplicarse en cualquier nivel del flujo de la señal de vídeo (evento, pista o nivel de salida).

Sony Vegas permite:

-Edición mediante uso de scripts, esto permite automatizar ciertas tareas de edición. Hay scripts de pago y gratuitos disponibles en la comunidad de Sony Vegas.

-Usar un proyecto como base para el desarrollo de otros proyectos, ahorrando así tiempo en realizar tareas comunes a estos dos.

-Edición muy completa de audio, aunque desgraciadamente, no admite el uso del formato MIDI.

Para más información: SonyVegasPro

- CyberLink PowerDirector.

CyberLink PowerDirector es uno de los múltiples y novedosos softwares que forman parte del conjunto de herramientas CyberLink. Desarrollado en China, powerDirector permite, en particular, la edición de vídeo de manera no lineal.

Su funcionalidad es similar a los editores ya mencionados, aunque en este caso, ha tenido un gran auge debido al soporte de publicación de los vídeos directamente en plataformas web y redes sociales; está orientado a la edición de vídeo para el entretenimiento web. Permite publicar los vídeos directamente en Youtube, en Facebook, cambiar el formato de un vídeo para que una consola sea capaz de reproducirlo, etc.

En el último año ha sido nombrado mejor herramienta de edición de vídeo por múltiples páginas webs, además de recibir premios de algunas de estas.

Para más información: CyberLink

Conclusiones

[editar]- El procesamiento digital son tópicos que se utilizan cada vez más en diversas áreas como la publicidad, cinematografía, meteorología, medicina, etc.

- El aprovechar el alto rendimiento para procesar vía digital tanto vídeos, imágenes, texto, etc. permite implementar sistemas de procesamiento digital cada vez mejores.

- El uso de nuevas tecnologías que nos permita procesar tanto vídeo, imágenes, texto, etc. y nos brindan las herramientas necesarias para el desarrollo de nuevos formatos y su manipulación.

- Existen una inmensa variedad de herramientas de edición de vídeo dependiendo del conocimiento que tengamos en la manipulación de las mismas, desde un nivel de principiante a un nivel mucho más avanzado.

Lecciones Relacionadas

[editar]Esta lección esta relacionada con:

Cuestionarios

[editar]